线性判别式的最简单形式是取输入向量的线性函数,即

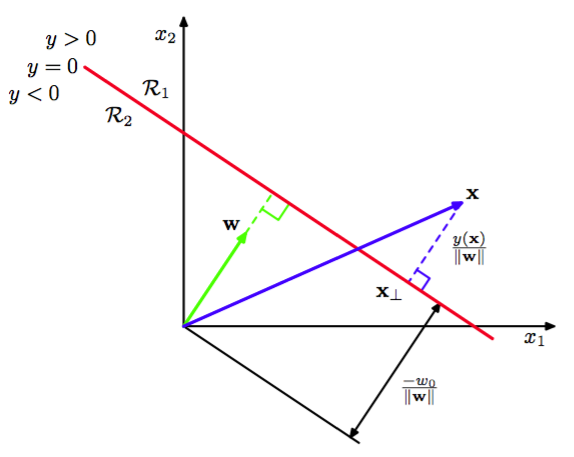

其中被称为权向量(weight vector),是偏置(不要与统计中的偏置混淆)。偏置的相反数有时被称为阈值(threshold)。如果则把输入向量分到类中,否则分到中。因此,对应的决策边界由确定,它对应着维空间中的一个维超平面。考虑两个点都处在超平面上的情形。由于,得到,所以向量与在决策面上的所有向量都正交,因此确定了决策面的方向。同样的,如果在决策面,那么,所以原点到决策面的标准距离由

所以我们看到偏置参数确定了决策面的位置。图4.1阐释了情况下的这些性质。

图 4.1 二维线性判别函数的几何表示

此外,我们注意到的值给出了点到决策面的垂直距离的一个有符号的度量。为了证明这点,考虑任意点并令是它在决策面上的正交投影,即

两边同时乘以并加上,再利用得到

图4.1阐释的这个结果。

与第3章线性回归模型相同,有时引入一个额外的虚“输入”来使记号更简洁,会比较方便。然后定义,然后

在这种情况下,决策面是一个穿过维扩展输入空间原点的维超平面。